W dzisiejszych czasach sztuczna inteligencja (AI) coraz śmielej wkracza w obszary, które do niedawna wydawały się zarezerwowane wyłącznie dla ludzkiej wrażliwości. Muzyka, ze swoją złożonością, emocjonalnością i kulturowym kontekstem, jest jednym z takich fascynujących pól. Zastanawialiście się kiedyś, jak algorytmy, które napędzają Wasze ulubione serwisy streamingowe, „rozumieją” to, co słyszą? Od surowych danych dźwiękowych, przez rozpoznawanie emocji, po kategoryzację gatunków AI potrafi wyodrębnić z muzyki zaskakująco wiele informacji, otwierając przed nami nowe perspektywy w tworzeniu, analizowaniu i doświadczaniu dźwięku.

Jak AI analizuje muzykę? Od cyfrowych fal po emocje i gatunki

- AI nie "słucha" muzyki, lecz przetwarza ją na dane liczbowe, analizując cechy takie jak częstotliwość, tempo czy barwa dźwięku.

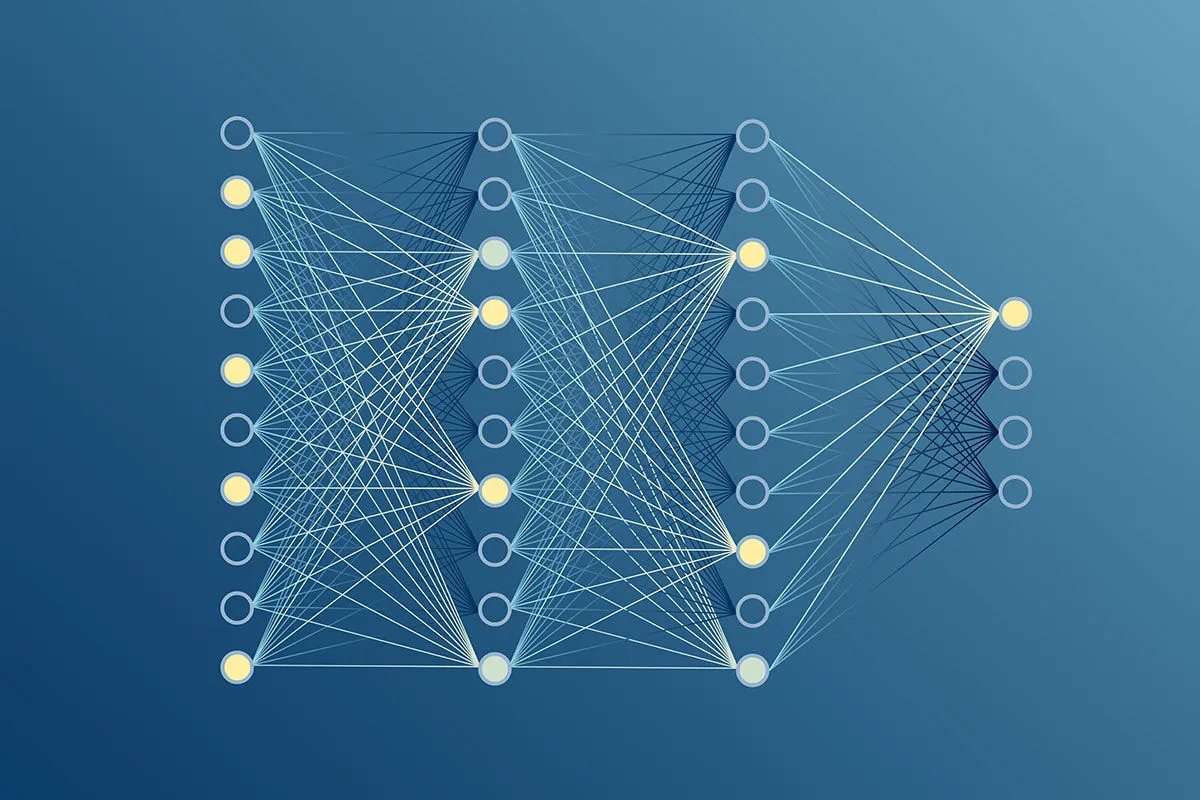

- Wykorzystuje zaawansowane sieci neuronowe (CNN, RNN) do identyfikacji wzorców w dźwięku i sekwencjach muzycznych.

- Potrafi klasyfikować utwory według gatunku, nastroju, a nawet rozpoznawać emocje i kontekst użytkowania.

- Analizuje również teksty piosenek za pomocą przetwarzania języka naturalnego (NLP), wyodrębniając tematykę i sentyment.

- Technologie te napędzają systemy rekomendacji w serwisach streamingowych i umożliwiają separację ścieżek dźwiękowych.

- AI potrafi także przewidywać przyszłe hity i generować nową muzykę.

Od fali dźwiękowej do danych: Pierwszy krok w cyfrowym uchu AI

Kiedy mówimy, że AI „słucha” muzyki, musimy pamiętać, że to tylko metafora. Sztuczna inteligencja nie doświadcza dźwięku w sposób, w jaki robi to człowiek, z całą jego subiektywnością i bogactwem emocji. Dla algorytmu plik audio to nic innego jak ciąg danych numerycznych. Pierwszym i fundamentalnym krokiem jest konwersja tej surowej fali dźwiękowej na zrozumiałe dla maszyny cechy. Proces ten, nazywany ekstrakcją cech, polega na wyodrębnianiu z dźwięku mierzalnych parametrów, takich jak częstotliwość (wysokość dźwięku), amplituda (głośność), tempo (BPM uderzenia na minutę), tonacja (czy utwór jest w dur, czy w moll), rytm oraz barwa dźwięku (timbre), która pozwala odróżnić np. trąbkę od skrzypiec grających tę samą nutę. To właśnie te liczby stają się paliwem dla dalszej, bardziej zaawansowanej analizy.

Czym jest spektrogram i dlaczego AI woli "patrzeć" na muzykę?

Wyobraźmy sobie, że zamiast próbować „słuchać” surowego ciągu liczb, AI może na muzykę „patrzeć”. I to właśnie robi dzięki spektrogramom. Spektrogram to nic innego jak wizualna reprezentacja dźwięku, która pokazuje, jak zmieniają się częstotliwości w czasie. Na osi poziomej mamy czas, na pionowej częstotliwość, a intensywność koloru w danym punkcie reprezentuje amplitudę (głośność) danej częstotliwości w danym momencie. Dla algorytmów AI, a zwłaszcza dla konwolucyjnych sieci neuronowych (CNN), „patrzenie” na muzykę w tej formie jest znacznie bardziej efektywne niż analiza surowej fali dźwiękowej. Dlaczego? Ponieważ CNN-y są mistrzami w analizie obrazów. Spektrogram staje się więc dla nich rodzajem „obrazu muzyki”, na którym mogą identyfikować wzorce, tekstury i struktury, podobnie jak rozpoznają twarze czy obiekty na zdjęciach. To kluczowy element w tym, jak maszyny zaczynają „rozumieć” muzykę.

Kluczowe cechy dźwięku, na które polują algorytmy: Tempo, tonacja i barwa

Poza spektrogramami, algorytmy AI skupiają się na wydobywaniu z muzyki konkretnych, fundamentalnych cech, które są jak klocki Lego, z których zbudowany jest każdy utwór. Oto te najważniejsze, na które algorytmy AI "polują":

- Tempo (BPM Beats Per Minute): To, jak szybko lub wolno utwór jest grany. Algorytmy precyzyjnie mierzą liczbę uderzeń na minutę, co jest kluczowe do kategoryzacji muzyki pod kątem aktywności (np. szybka muzyka do biegania, spokojna do relaksu).

- Tonacja (Dur vs. Moll): To jeden z najważniejszych elementów wpływających na emocjonalny wydźwięk utworu. Tonacje durowe często kojarzone są z radością i optymizmem, natomiast molowe z melancholią i smutkiem. AI potrafi z dużą dokładnością określać tonację, co jest fundamentem do rozpoznawania nastroju.

- Barwa dźwięku (Timbre): To unikalna jakość dźwięku, która pozwala odróżnić instrumenty od siebie, nawet jeśli grają tę samą nutę z tą samą głośnością. Algorytmy analizują spektrum harmonicznych dźwięku, aby rozpoznać, czy mamy do czynienia z gitarą, fortepianem, czy syntezatorem. To niezwykle ważne dla identyfikacji gatunków i stylów.

Te elementy, choć wydają się proste, są fundamentalne dla dalszej, bardziej złożonej klasyfikacji i interpretacji muzyki przez algorytmy. To na ich podstawie budowane są bardziej abstrakcyjne wnioski.

Algorytmy w akcji: Technologie AI w analizie muzyki

Kiedy już mamy dane czy to w postaci liczb, czy spektrogramów czas na to, by algorytmy zaczęły działać. To tutaj wkraczają zaawansowane technologie sztucznej inteligencji, które potrafią wyłapać z tych danych wzorce i zależności, często niewidoczne dla ludzkiego ucha.

Konwolucyjne sieci neuronowe (CNN) jako tropiciele muzycznych wzorców

Jak już wspomniałem, konwolucyjne sieci neuronowe (CNN) są prawdziwymi mistrzami w analizie wizualnej. W kontekście muzyki, ich rola staje się kluczowa, gdy dane dźwiękowe są przekształcane w spektrogramy. CNN-y potrafią skanować te „obrazy muzyki” w poszukiwaniu specyficznych wzorców na przykład charakterystycznych dla danego instrumentu harmonicznych, unikalnych dla gatunku tekstur rytmicznych czy powtarzających się struktur melodycznych. Działają podobnie jak w przypadku analizy zdjęć, gdzie identyfikują krawędzie, kształty i tekstury, by ostatecznie rozpoznać obiekt. W muzyce pozwala im to na rozpoznawanie specyficznych struktur dźwiękowych, które są sygnaturą konkretnego gatunku, nastroju czy nawet artysty.

Rola sieci rekurencyjnych (RNN) w rozumieniu melodii i harmonii

Muzyka to nie tylko pojedyncze dźwięki, ale przede wszystkim sekwencje melodie, progresje akordów, rytmy, które rozwijają się w czasie. I tutaj na scenę wkraczają rekurencyjne sieci neuronowe (RNN). W przeciwieństwie do CNN-ów, które skupiają się na lokalnych wzorcach, RNN-y są specjalnie zaprojektowane do przetwarzania danych sekwencyjnych, czyli takich, gdzie kolejność ma znaczenie. Dzięki swojej wewnętrznej „pamięci” potrafią zapamiętywać informacje z poprzednich kroków i wykorzystywać je do interpretacji bieżących. To właśnie pozwala im rozumieć, jak akordy następują po sobie, jak rozwija się melodia, czy jak zmienia się rytm w ciągu utworu. Są niezastąpione w analizie struktury muzycznej i jej ewolucji w czasie.

Uczenie maszynowe w praktyce: Jak AI trenuje się na milionach utworów?

Cała ta zaawansowana analiza nie byłaby możliwa bez intensywnego procesu uczenia maszynowego. Wyobraźcie sobie, że algorytm AI jest jak student, który musi przyswoić wiedzę z ogromnej biblioteki muzycznej. Ten „student” jest trenowany na ogromnych zbiorach danych muzycznych często liczących miliony utworów. Podczas tego treningu, algorytm otrzymuje dane wejściowe (np. spektrogramy lub wyekstrahowane cechy) oraz odpowiadające im etykiety (np. „rock”, „radosny”, „gitara”). Na podstawie tych par danych i etykiet, AI uczy się identyfikować wzorce i zależności. Z czasem, dzięki iteracyjnym procesom optymalizacji, algorytm staje się coraz lepszy w rozpoznawaniu cech, klasyfikowaniu utworów i przewidywaniu ich właściwości. To właśnie dzięki temu procesowi, AI może z coraz większą precyzją „zrozumieć” i opisać muzykę.

Co AI potrafi wyczytać z Twojej ulubionej piosenki?

Gdy algorytmy AI już opanują sztukę analizy dźwięku i rozpoznawania wzorców, otwierają się przed nimi drzwi do znacznie bardziej zaawansowanych interpretacji. To, co potrafią wyczytać z utworu, często wykracza poza nasze codzienne postrzeganie muzyki.

Automatyczne tagowanie: Jak AI przypisuje gatunek i nastrój?

Jednym z najbardziej powszechnych i użytecznych zastosowań analizy muzyki przez AI jest automatyczne tagowanie. Na podstawie wyodrębnionych cech tempa, tonacji, barwy instrumentów, struktury rytmicznej algorytmy potrafią z dużą dokładnością klasyfikować piosenki. To właśnie dzięki nim utwory są automatycznie przypisywane do konkretnych gatunków, takich jak rock, pop, jazz, elektronika czy hip-hop. Ale to nie wszystko! AI jest w stanie również określić nastrój utworu (np. radosny, smutny, energetyczny, spokojny) oraz jego kontekst użytkowania (np. „muzyka do biegania”, „muzyka do nauki”, „muzyka do relaksu”). To kluczowa funkcja dla serwisów streamingowych, które wykorzystują te tagi do tworzenia spersonalizowanych playlist i rekomendacji, o czym opowiem za chwilę.

Analiza emocji w muzyce: Czy algorytm potrafi wyczuć smutek i euforię?

Rozpoznawanie emocji w muzyce (Music Emotion Recognition MER) to jeden z najbardziej intrygujących i jednocześnie najtrudniejszych obszarów badań AI. Chociaż maszyna nie czuje emocji w ludzki sposób, potrafi analizować kombinacje parametrów, które są z nimi powiązane. AI bada, jak tempo (szybkie tempo często kojarzy się z radością, wolne ze smutkiem), tonacja (dur z pozytywnymi emocjami, moll z negatywnymi), dynamika (głośność i jej zmiany) oraz instrumentacja (np. smyczki często wzmacniają melancholię, a dęte blaszane triumf) wpływają na ogólny wydźwięk utworu. Najnowsze modele są w stanie rozróżniać coraz bardziej subtelne odcienie emocji, co pozwala na tworzenie playlist idealnie dopasowanych do naszego nastroju, a nawet na wspieranie terapii muzyką.

Rozkładanie utworu na czynniki pierwsze: Separacja wokalu, basu i perkusji

Wyobraźcie sobie, że macie gotowy utwór, a potrzebujecie samej ścieżki wokalnej do remiksu, albo samej perkusji do ćwiczeń. Kiedyś było to niezwykle trudne, a często wręcz niemożliwe bez dostępu do oryginalnych ścieżek nagraniowych. Dziś, dzięki nowoczesnym algorytmom AI, takim jak te oparte na modelu Demucs od Meta AI, możliwe jest separowanie źródeł dźwięku z dużą precyzją. AI potrafi z gotowego utworu wyodrębnić wokal, perkusję, bas oraz inne instrumenty, tworząc z nich osobne ścieżki. To prawdziwy przełom dla producentów muzycznych, DJ-ów, którzy mogą tworzyć remiksy, mashupy, a także dla muzyków, którzy chcą ćwiczyć z podkładem bez wokalu czy z wyciszonym konkretnym instrumentem. To pokazuje, jak AI nie tylko analizuje, ale i manipuluje dźwiękiem na niespotykane dotąd sposoby.

Kiedy AI czyta między wierszami: Analiza tekstów piosenek

Muzyka to często nie tylko melodia i harmonia, ale także słowa. Kiedy utwór zawiera wokal, sztuczna inteligencja wykorzystuje kolejny potężny zestaw narzędzi, aby „czytać między wierszami” i wydobywać znaczenie z tekstów piosenek. To dziedzina, w której AI łączy analizę dźwięku z rozumieniem języka.

Przetwarzanie języka naturalnego (NLP) w służbie muzyki

W przypadku piosenek z wokalem, do gry wkracza przetwarzanie języka naturalnego (NLP). To gałąź AI, która zajmuje się interakcją między komputerami a językiem ludzkim. Algorytmy NLP analizują teksty piosenek, aby zrozumieć ich strukturę, gramatykę, słownictwo i kontekst. Dzięki temu AI może nie tylko transkrybować teksty, ale także je interpretować, co jest kluczowe dla pełniejszego zrozumienia utworu. To tak, jakby algorytm stawał się krytykiem literackim, który potrafi rozłożyć wiersz na czynniki pierwsze, ale robi to w ułamku sekundy.

Wykrywanie sentymentu: Co tekst piosenki mówi o jej emocjach?

Jednym z najbardziej fascynujących zastosowań NLP w muzyce jest wykrywanie sentymentu. Algorytmy analizują słowa i frazy w tekście piosenki, aby określić ich wydźwięk emocjonalny czy są pozytywne, negatywne, czy neutralne. Dzięki temu AI może potwierdzić lub uzupełnić analizę emocji z samej muzyki. Jeśli melodia jest melancholijna, a tekst pełen słów takich jak „smutek”, „rozstanie”, „ból”, algorytm z dużą pewnością określi utwór jako smutny. To pozwala na jeszcze bardziej precyzyjne kategoryzowanie utworów pod kątem nastroju i dopasowywanie ich do oczekiwań słuchaczy.

Identyfikacja tematów i motywów lirycznych przez algorytmy

Poza sentymentem, algorytmy AI potrafią również identyfikować kluczowe tematy, motywy i powtarzające się frazy w tekstach piosenek. Czy utwór opowiada o miłości, stracie, nadziei, buncie, czy może o problemach społecznych? AI jest w stanie wyłapać te dominujące wątki, analizując częstość występowania konkretnych słów i ich kontekst. To dostarcza głębszej analizy treści lirycznej, która może być wykorzystana do tworzenia bardziej szczegółowych tagów, budowania playlist tematycznych, a nawet do wspierania artystów w procesie twórczym, sugerując im popularne lub innowacyjne motywy liryczne. To pokazuje, jak AI staje się narzędziem, które potrafi zrozumieć nie tylko to, jak muzyka brzmi, ale także o czym opowiada.

AI w Twoim odtwarzaczu: Praktyczne zastosowania analizy muzyki

Wszystkie te zaawansowane techniki analizy muzyki przez AI nie są tylko teoretycznymi koncepcjami. Mają one bardzo realne i namacalne zastosowania w naszym codziennym życiu, zwłaszcza w sposobie, w jaki odkrywamy i konsumujemy muzykę.

Silniki rekomendacji w Spotify i Apple Music: Jak to działa "pod maską"?

To prawdopodobnie najbardziej znane zastosowanie AI w muzyce. Kiedy otwierasz Spotify, Apple Music czy inny serwis streamingowy, za spersonalizowanymi playlistami i rekomendacjami stoi potężna machina AI. Algorytmy analizują Twoje nawyki słuchania jakie gatunki lubisz, jacy artyści Cię interesują, jakie nastroje preferujesz, a nawet o jakiej porze dnia słuchasz konkretnych typów muzyki. Następnie, wykorzystując wspomnianą klasyfikację gatunków, nastrojów i kontekstów, AI porównuje Twój profil z milionami utworów w bazie. Szuka podobieństw między utworami, które lubisz, a tymi, których jeszcze nie słyszałeś, a także analizuje preferencje innych użytkowników o podobnych gustach. To złożony system, który uczy się na bieżąco, dostosowując rekomendacje, abyś zawsze miał coś nowego i trafionego do odkrycia. To prawdziwa magia, która sprawia, że muzyka wydaje się być szyta na miarę Twoich upodobań.

Przewidywanie przyszłych hitów: Czy AI może być łowcą talentów?

Branża muzyczna to ogromny biznes, a odkrywanie przyszłych hitów to prawdziwa sztuka. Okazuje się, że AI może w tym pomóc. Modele sztucznej inteligencji są trenowane na tysiącach, a nawet milionach piosenek, które w przeszłości stały się przebojami. Analizują one struktury piosenek, progresje akordów, tempo, tonację, barwę instrumentów, a nawet "chwytliwość" refrenu, aby zidentyfikować cechy wspólne dla komercyjnych sukcesów. Firmy z branży muzycznej, takie jak Warner Music, wykorzystują te algorytmy do prognozowania komercyjnego potencjału nowych utworów. AI nie zastępuje intuicji łowców talentów, ale dostarcza im potężnych narzędzi analitycznych, które mogą wskazać, które piosenki mają największe szanse na podbicie list przebojów. To fascynujące, jak maszyna może próbować przewidzieć, co "chwyci" w sercach milionów słuchaczy.

Nowe narzędzia dla muzyków i producentów oparte na AI

AI to nie tylko narzędzie dla słuchaczy i gigantów streamingowych, ale także potężny sojusznik dla samych twórców muzyki. Sztuczna inteligencja otwiera przed muzykami i producentami zupełnie nowe możliwości:

- Separacja źródeł dźwięku: Jak już wspomniałem, możliwość wyodrębnienia wokalu, perkusji czy basu z gotowego utworu jest nieoceniona dla DJ-ów, producentów remiksów, a także dla muzyków, którzy chcą ćwiczyć z podkładem.

- Narzędzia do masteringu i miksowania: AI może analizować utwór i sugerować optymalne ustawienia korekcji, kompresji czy pogłosu, a nawet automatycznie poprawiać balans miksu, oszczędzając producentom mnóstwo czasu.

- Generowanie wstępnych pomysłów i melodii: Niektóre algorytmy potrafią generować krótkie fragmenty muzyczne, progresje akordów czy linie melodyczne w określonym stylu. To świetne narzędzie do przełamywania blokady twórczej i generowania inspiracji.

- Transkrypcja i analiza nutowa: AI potrafi automatycznie transkrybować nagrania audio na zapis nutowy, co jest ogromną pomocą dla kompozytorów i aranżerów.

Wszystkie te zastosowania pokazują, że AI nie jest tu, aby zastąpić kreatywność, lecz aby ją wspomagać i rozszerzać, dając artystom nowe narzędzia do realizacji ich wizji.

Przyszłość muzyki z AI: Synergia czy zastąpienie?

Gdy patrzymy na to, co AI potrafi już dziś w dziedzinie muzyki, naturalnie pojawia się pytanie o przyszłość. Czy maszyny w końcu dorównają, a może nawet przewyższą ludzką wrażliwość muzyczną? Czy sztuczna inteligencja zastąpi artystów, czy raczej stanie się ich najlepszym partnerem?

Granice percepcji AI: Czego maszyny wciąż nie rozumieją w muzyce?

Pomimo imponujących osiągnięć, musimy pamiętać o granicach percepcji AI. Maszyny wciąż nie są w stanie w pełni zrozumieć wielu aspektów muzyki, które dla nas, ludzi, są kluczowe. Nie rozumieją prawdziwych emocji potrafią je jedynie naśladować i identyfikować wzorce z nimi związane, ale nie doświadczają ich. Brakuje im głębokiego kontekstu kulturowego, który często nadaje muzyce sens, ani subiektywnej interpretacji, która sprawia, że ten sam utwór może wywoływać różne odczucia u różnych osób. AI nie ma „duszy” ani intencji artystycznej. Nie tworzy muzyki, bo czuje potrzebę wyrażenia siebie, a jedynie na podstawie algorytmów i danych, na których została wytrenowana. To są te subtelne, niemierzalne aspekty, które wciąż pozostają poza zasięgiem maszyn.

Przeczytaj również: Stwórz własną AI: Jak zacząć od zera? Kompletny przewodnik

Synergia czy rywalizacja? Jak współpraca z AI zmienia proces twórczy

Patrząc na przyszłość, jestem przekonany, że nie czeka nas rywalizacja, lecz synergia między ludźmi a AI w muzyce. Sztuczna inteligencja nie zastąpi artystów, ale stanie się ich potężnym narzędziem, rozszerzającym ludzką kreatywność. Wyobraźmy sobie AI jako niezwykle utalentowanego asystenta, który potrafi automatyzować rutynowe zadania, takie jak miksowanie, mastering, generowanie wstępnych pomysłów melodycznych czy nawet tworzenie wariacji na dany temat. To pozwoli artystom skupić się na tym, co najważniejsze na wizji artystycznej, na przekazywaniu emocji, na innowacji i na tym unikalnym, ludzkim pierwiastku, który sprawia, że muzyka porusza. AI może otwierać nowe możliwości twórcze, eksplorować nieznane brzmienia i struktury, a jednocześnie uwalniać artystów od żmudnych, technicznych aspektów produkcji. To będzie fascynująca podróż, w której technologia i ludzka wrażliwość będą się wzajemnie uzupełniać, tworząc muzykę, jakiej jeszcze nie słyszeliśmy.