Ten artykuł zabierze Cię w fascynującą podróż przez historię sztucznej inteligencji, od jej filozoficznych korzeni po współczesne osiągnięcia. Dowiedz się, jak ewoluowała ta przełomowa dziedzina, poznaj kluczowe postacie i wydarzenia, które ukształtowały AI, i zrozum, dlaczego jest ona tak ważna dla naszej przyszłości.

Sztuczna inteligencja narodziła się z marzeń o myślących maszynach poznaj kluczowe etapy jej ewolucji.

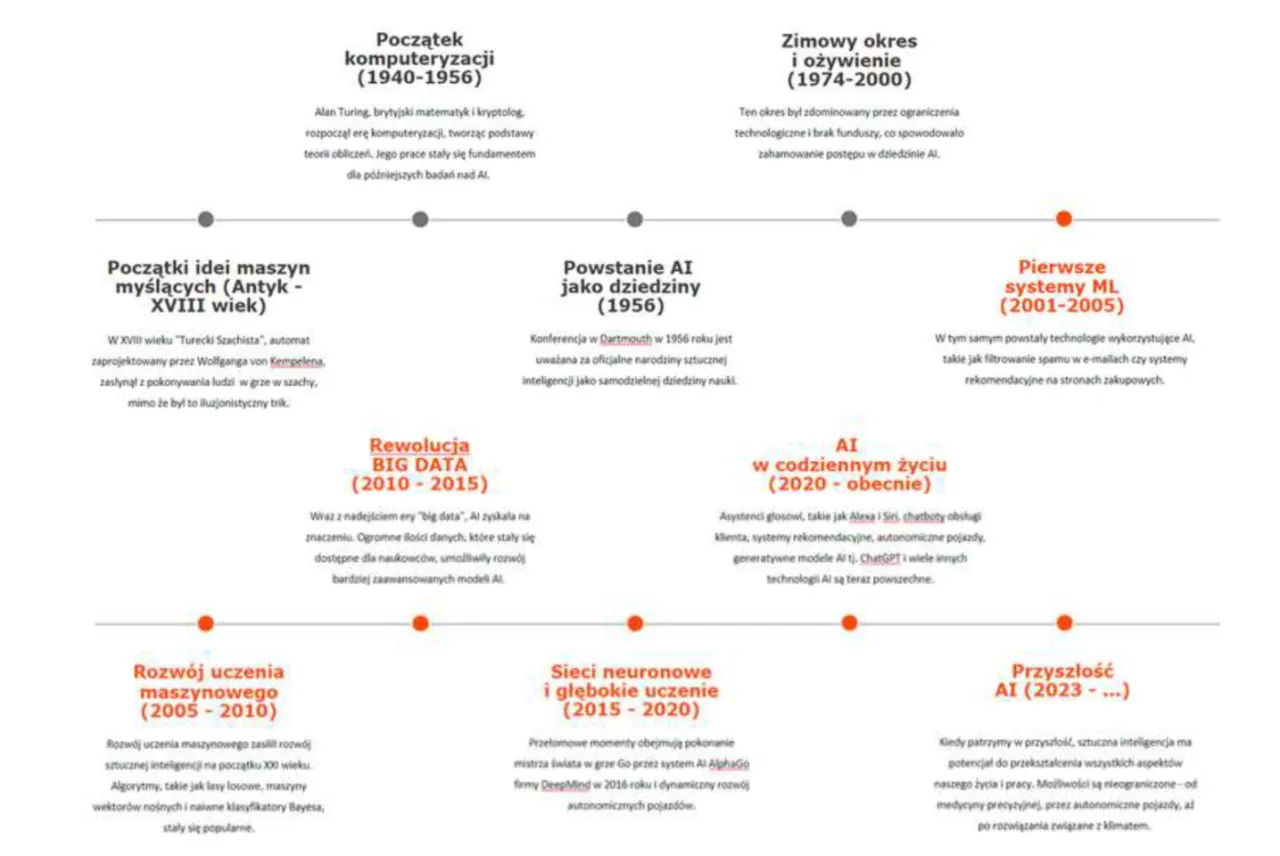

- Teoretyczne podstawy AI sięgają starożytności, ale naukowe fundamenty to prace Alana Turinga (maszyna Turinga, Test Turinga) z pierwszej połowy XX wieku.

- Termin "sztuczna inteligencja" został ukuty przez Johna McCarthy'ego w 1956 roku na konferencji w Dartmouth, uznawanej za oficjalny początek dziedziny.

- Wczesne lata to optymizm i sukcesy (programy do gier, rozwiązywania problemów), ale też "zimy AI" z powodu ograniczeń technologicznych i rozczarowań.

- Renesans w latach 80. przyniósł systemy ekspertowe, a prawdziwy przełom nastąpił dzięki uczeniu maszynowemu, Big Data i głębokim sieciom neuronowym od lat 90.

- Kluczowe postacie to Alan Turing, John McCarthy, a także Geoffrey Hinton, Yann LeCun i Yoshua Bengio, "ojcowie chrzestni" głębokiego uczenia.

- Współczesna AI to m.in. modele generatywne, a Polska ma swój wkład w rozwój tej dziedziny.

Filozoficzne i matematyczne korzenie sztucznej inteligencji

Zanim sztuczna inteligencja stała się dziedziną nauki i inżynierii, istniała w sferze ludzkich marzeń i filozoficznych rozważań. Już w starożytności ludzie fantazjowali o tworzeniu istot, które potrafiłyby myśleć i działać jak oni. To właśnie te wczesne koncepcje położyły podwaliny pod to, co dziś nazywamy AI.

Od mechanicznych automatów do marzeń o myślących maszynach

Koncepcje myślących maszyn i mechanicznych automatów pojawiały się w mitach i wczesnych pracach filozoficznych na długo przed erą komputerów. Starożytni Grecy snuli opowieści o Talosie, spiżowym gigancie chroniącym Kretę, czy o mechanicznych zabawkach Hefajstosa. W średniowieczu i renesansie alchemicy i inżynierowie, tacy jak Albert Wielki czy Leonardo da Vinci, projektowali lub tworzyli skomplikowane automaty, które naśladowały ludzkie ruchy. Te wczesne idee, choć dalekie od współczesnej AI, stanowiły prekursorskie marzenia o tworzeniu inteligencji poza biologicznym ciałem.

Alan Turing prorok cyfrowej ery i jego fundamentalne pytanie

Prawdziwy przełom nastąpił jednak w XX wieku. Kluczową postacią, bez której historia AI wyglądałaby zupełnie inaczej, jest bez wątpienia Alan Turing. Ten brytyjski matematyk i logik, często nazywany ojcem informatyki teoretycznej, w 1936 roku opublikował pracę wprowadzającą koncepcję „maszyny Turinga”. Był to teoretyczny model urządzenia zdolnego do wykonywania dowolnych obliczeń, pod warunkiem, że można je sprowadzić do sekwencji prostych kroków. Maszyna Turinga, choć abstrakcyjna, stała się fundamentem dla zrozumienia, co jest obliczalne, a co nie, i utorowała drogę do powstania współczesnych komputerów. Jego wizjonerskie podejście pokazało, że złożone procesy myślowe mogą być w zasadzie zredukowane do algorytmów.

Czym jest Test Turinga i dlaczego do dziś budzi kontrowersje?

W 1950 roku Alan Turing zadał fundamentalne pytanie: "Czy maszyny mogą myśleć?". Aby na nie odpowiedzieć, zaproponował słynny "Test Turinga". W jego pierwotnym założeniu, osoba oceniająca prowadzi rozmowę tekstową z dwoma niewidocznymi dla niej rozmówcami: człowiekiem i maszyną. Jeśli oceniający nie jest w stanie odróżnić maszyny od człowieka, to maszyna zdała test. Celem było sprawdzenie, czy maszyna potrafi wykazywać zachowania inteligentne, nierozróżnialne od ludzkich. Do dziś Test Turinga pozostaje przedmiotem intensywnych dyskusji i kontrowersji. Krytycy wskazują, że test mierzy jedynie zdolność maszyny do imitowania ludzkiej rozmowy, a nie rzeczywistą inteligencję czy świadomość. Mimo to, pozostaje on ważnym punktem odniesienia w debacie nad definicją inteligencji maszynowej i inspiruje badaczy do tworzenia coraz bardziej zaawansowanych systemów konwersacyjnych.

Moment narodzin: Konferencja w Dartmouth i nazwa nowej nauki

Po teoretycznych fundamentach Alana Turinga, nadszedł czas na oficjalne narodziny nowej dziedziny. To wydarzenie na zawsze zmieniło bieg historii technologii i nauki.

Rok 1956: Spotkanie ojców założycieli sztucznej inteligencji

Oficjalnym momentem narodzin dziedziny sztucznej inteligencji jest konferencja w Dartmouth College w lecie 1956 roku. To właśnie tam, podczas dwumiesięcznego warsztatu, grupa wybitnych naukowców zebrała się, aby przedyskutować możliwości tworzenia "maszyn, które imitują inteligencję". Kluczowe jest to, że to właśnie na tej konferencji John McCarthy po raz pierwszy użył terminu "artificial intelligence" (sztuczna inteligencja), nadając nazwę nowej, obiecującej dziedzinie. To wydarzenie uznawane jest za kamień milowy, który wytyczył kierunek badań na kolejne dekady.

Kim byli John McCarthy, Marvin Minsky i Herbert Simon?

Konferencja w Dartmouth zgromadziła prawdziwych wizjonerów. Oto kilku z nich:

John McCarthy: Matematyk i informatyk, który nie tylko ukuł termin "sztuczna inteligencja", ale także był jednym z głównych organizatorów konferencji. Jego wkład w rozwój AI, w tym stworzenie języka programowania LISP, jest nieoceniony.

Marvin Minsky: Informatyk i kognitywista, współzałożyciel Laboratorium AI na MIT. Był pionierem w dziedzinie sieci neuronowych i robotyki, a jego prace miały ogromny wpływ na wczesny rozwój AI.

Allen Newell i Herbert A. Simon: Ci dwaj naukowcy z Carnegie Mellon University byli twórcami programu Logic Theorist, jednego z pierwszych programów AI, który potrafił dowodzić twierdzeń matematycznych. Ich podejście do rozwiązywania problemów i modelowania ludzkiego myślenia było przełomowe.

Wielkie obietnice i wszechobecny optymizm pierwsza złota era AI

Lata 50. i 60. to okres ogromnego optymizmu i entuzjazmu wokół nowo narodzonej dziedziny AI. Badacze wierzyli, że w ciągu kilku dekad uda im się stworzyć maszyny o inteligencji dorównującej, a może nawet przewyższającej ludzką. Pojawiły się pierwsze, imponujące jak na tamte czasy, sukcesy, które podsycały te nadzieje. Wśród nich warto wymienić:

- Logic Theorist (1956): Program stworzony przez Newella, Simona i Cliffa Shawa, który potrafił dowodzić twierdzeń matematycznych z dzieła "Principia Mathematica" Russella i Whiteheada.

- Geometry Theorem Prover (1959): Program Herberta Simona, który dowodził twierdzeń geometrycznych.

- Programy do gier: Powstały programy zdolne do grania w szachy (np. program Alexa Bernsteina) i warcaby (program Arthura Samuela, który potrafił się uczyć na podstawie własnych doświadczeń).

- Perceptron Franka Rosenblatta (1957): Wczesny model sieci neuronowej, który potrafił uczyć się rozpoznawania wzorców. Choć jego możliwości były ograniczone, był to ważny krok w kierunku uczenia maszynowego.

Te osiągnięcia sprawiły, że wielu badaczy i decydentów wierzyło, że pełna sztuczna inteligencja jest tuż za rogiem.

Wzloty i upadki: Burzliwa historia rozwoju AI

Jak to często bywa z nowymi, rewolucyjnymi technologiami, po okresie euforii nadszedł czas na zderzenie z rzeczywistością. Historia AI to opowieść o cyklach optymizmu i rozczarowania, które doprowadziły do czegoś, co nazywamy "zimami AI".

Nadeszła "zima AI": Kiedy fundusze wyschły, a entuzjazm opadł

Po początkowych sukcesach i wielkich obietnicach, lata 70. i wczesne 80. przyniosły pierwszą "zimę AI". Entuzjazm opadł, a fundusze na badania zaczęły wysychać. Przyczyny tego były złożone. Po pierwsze, ówczesna moc obliczeniowa była niewystarczająca do realizacji ambitnych celów. Programy działały na małych zbiorach danych i w ściśle określonych domenach, a ich skalowanie do problemów świata rzeczywistego okazywało się niezwykle trudne. Po drugie, wiele początkowych obietnic okazało się niemożliwych do spełnienia, co wywołało rozczarowanie. Krytyka, jak np. słynny raport Lighthilla z 1973 roku w Wielkiej Brytanii, wskazywała na brak znaczących postępów i nadmierne oczekiwania. W rezultacie, inwestycje w AI drastycznie spadły, a wielu badaczy porzuciło tę dziedzinę.

Powrót do łask: Czym były systemy ekspertowe i jak zmieniły biznes?

Renesans AI nastąpił w latach 80. dzięki pojawieniu się i komercyjnemu sukcesowi systemów ekspertowych. Były to programy zaprojektowane do naśladowania procesu decyzyjnego ludzkiego eksperta w bardzo wąskiej, specyficznej dziedzinie. Wykorzystywały one obszerne bazy wiedzy i zbiory reguł, aby diagnozować problemy, doradzać lub podejmować decyzje. Przykłady obejmują systemy medyczne (np. MYCIN do diagnozowania chorób krwi), finansowe (do analizy inwestycji) czy przemysłowe (do konfiguracji sprzętu). Systemy ekspertowe, choć ograniczone, pokazały, że AI może mieć praktyczne zastosowania i przynosić realne korzyści biznesowe, co na nowo przyciągnęło inwestorów i badaczy.

Niestety, sukces systemów ekspertowych był krótkotrwały. Pod koniec lat 80. i na początku 90. nadeszła kolejna "zima AI". Systemy te okazały się bardzo kosztowne w utrzymaniu i trudne w aktualizacji. Złożoność dodawania nowych reguł i wiedzy sprawiała, że szybko stawały się przestarzałe. Dodatkowo, były one bardzo kruche mała zmiana w danych wejściowych mogła prowadzić do całkowicie błędnych wniosków. Te ograniczenia, w połączeniu z rosnącymi kosztami, ponownie doprowadziły do spadku zainteresowania i finansowania badań nad AI, zwłaszcza tych opartych na symbolicznym podejściu.

Rewolucja głębokiego uczenia: Dane i moc obliczeniowa zmieniają wszystko

Po burzliwych dekadach wzlotów i upadków, nadszedł czas na prawdziwą rewolucję, która na zawsze zmieniła oblicze sztucznej inteligencji. To, co obserwujemy dzisiaj, jest w dużej mierze efektem głębokiego uczenia.

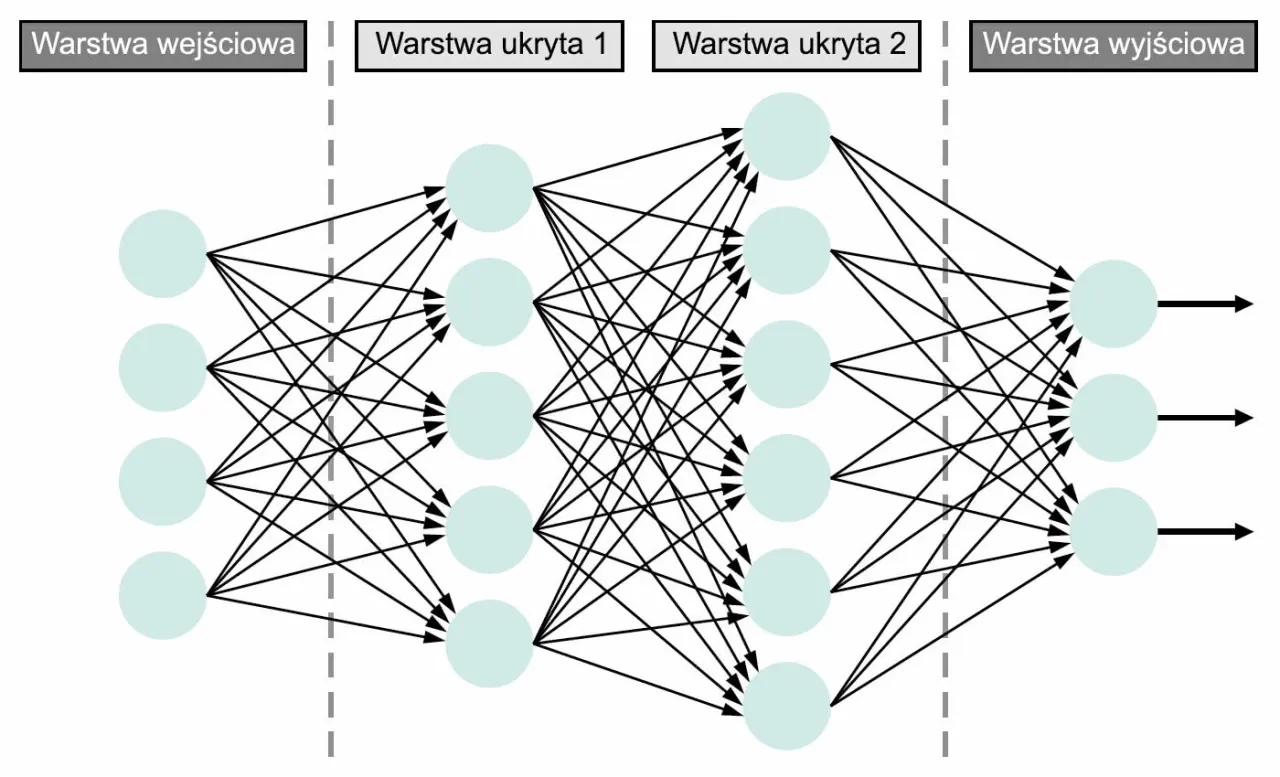

Przełom w sieciach neuronowych: Od perceptronu do deep learning

Prawdziwy przełom w AI, który obserwujemy od lat 90. i który nabrał tempa w XXI wieku, jest nierozerwalnie związany z rozwojem głębokich sieci neuronowych (deep learning). To podejście, choć teoretycznie znane od dawna (wspomniany wcześniej perceptron był jego prekursorem), przez lata było niedoceniane z powodu braku odpowiednich zasobów. Trzy kluczowe czynniki zbiegły się w czasie, umożliwiając ten renesans: ogromny wzrost mocy obliczeniowej (szczególnie dzięki kartom graficznym GPU), dostępność olbrzymich zbiorów danych (Big Data) oraz postęp w algorytmach uczenia maszynowego, które pozwoliły na efektywne trenowanie głębokich sieci z wieloma warstwami. Nagle, to co było niemożliwe, stało się osiągalne, otwierając drogę do niespotykanych wcześniej możliwości.

Deep Blue kontra Kasparow i AlphaGo kontra Sedol: Kamienie milowe w historii AI

Historia AI obfituje w momenty, które na zawsze zapisały się w świadomości publicznej, symbolizując przełomowe osiągnięcia maszyn. Dwa z nich są szczególnie znaczące.

Pierwszym był rok 1997, kiedy to komputer Deep Blue firmy IBM pokonał ówczesnego mistrza świata w szachach, Garriego Kasparowa. To wydarzenie było symbolicznym zwycięstwem czystej mocy obliczeniowej i algorytmów przeszukujących ogromne drzewa możliwości. Deep Blue nie "rozumiał" szachów w ludzki sposób, ale potrafił analizować miliony pozycji na sekundę, co pozwoliło mu przewyższyć ludzki umysł w tej konkretnej grze. Był to dowód na to, że maszyny mogą dominować w złożonych zadaniach opartych na regułach.

Drugim, jeszcze bardziej spektakularnym kamieniem milowym, było zwycięstwo programu AlphaGo firmy DeepMind (Google) nad Lee Sedolem, jednym z najlepszych graczy Go na świecie, w 2016 roku. Go to gra o znacznie większej złożoności niż szachy, z niemal nieskończoną liczbą możliwych ruchów, co sprawiało, że tradycyjne algorytmy przeszukujące były nieskuteczne. AlphaGo wykorzystał głębokie sieci neuronowe i uczenie wzmacniające, ucząc się gry poprzez miliony symulacji i rozgrywek z samym sobą. To zwycięstwo pokazało, że AI potrafi nie tylko dominować w zadaniach opartych na regułach, ale także radzić sobie z ogromną złożonością i uczyć się w sposób, który przypomina intuicję, co było prawdziwym przełomem.

"Ojcowie chrzestni" deep learningu: Hinton, LeCun i Bengio

Za rewolucją głębokiego uczenia stoją wybitni naukowcy, których prace miały fundamentalne znaczenie dla rozwoju tej dziedziny. Trzech z nich jest szczególnie często wymienianych jako "ojcowie chrzestni" deep learningu: Geoffrey Hinton, Yann LeCun i Yoshua Bengio. Ich badania nad architekturami sieci neuronowych, algorytmami uczenia (takimi jak propagacja wsteczna) oraz praktycznymi zastosowaniami głębokiego uczenia, zmieniły oblicze AI. Ich wspólny wkład został uhonorowany Nagrodą Turinga w 2018 roku, często nazywaną "Noblem informatyki", co tylko potwierdza ich kluczową rolę w tej rewolucji.

"Sztuczna inteligencja to przyszłość, która już tu jest. Zmienia sposób, w jaki żyjemy, pracujemy i myślimy." Nieznany autor

Od teorii do praktyki: Teraźniejszość i przyszłość AI

Dziś sztuczna inteligencja to nie tylko domena laboratoriów badawczych, ale także integralna część naszego codziennego życia. Od asystentów głosowych po zaawansowane systemy rekomendacji, AI jest wszędzie. Ale co dalej?

Generatywna AI: Jak modele językowe stały się częścią naszej codzienności

Ostatnie lata przyniosły kolejny, spektakularny rozwój w dziedzinie AI, a mianowicie generatywną AI. Duże modele językowe (LLM), takie jak GPT-3, GPT-4 czy LLaMA, stały się powszechne i zrewolucjonizowały sposób, w jaki ludzie wchodzą w interakcje z technologią. Są to modele zdolne do generowania tekstu, obrazów, a nawet kodu, które są niezwykle trudne do odróżnienia od tych stworzonych przez człowieka. Ich zastosowania w codziennym życiu są już niezliczone:

- Tworzenie tekstów: Od pisania e-maili i artykułów po generowanie kreatywnych opowiadań i wierszy.

- Tłumaczenia: Znacząco usprawnione i bardziej naturalne niż kiedykolwiek.

- Chatboty i wirtualni asystenci: Oferujące coraz bardziej płynne i pomocne interakcje.

- Kreatywność: Generowanie obrazów na podstawie opisu tekstowego (np. DALL-E, Midjourney), wspomaganie projektantów i artystów.

- Programowanie: Sugerowanie kodu, debugowanie i automatyzacja części procesów deweloperskich.

Wpływ generatywnej AI na różne dziedziny, od edukacji po przemysł, jest już ogromny i wciąż rośnie, zmieniając sposób, w jaki pracujemy, uczymy się i tworzymy.

Polski ślad w historii AI: Czy mamy się czym pochwalić?

Oczywiście, że tak! Polska, choć może nie jest na czele globalnej narracji o AI, ma swój znaczący wkład w rozwój tej dziedziny. Historycznie, polscy naukowcy wnieśli wiele do logiki matematycznej i cybernetyki, które są podstawą AI. Prace w dziedzinie rozpoznawania obrazów, lingwistyki komputerowej i systemów ekspertowych były prowadzone w Polsce już w drugiej połowie XX wieku. Dziś polscy naukowcy i inżynierowie aktywnie uczestniczą w globalnym rozwoju AI. Pracują w czołowych firmach technologicznych, prowadzą badania na renomowanych uczelniach i w instytutach, a także tworzą innowacyjne startupy. Mamy prężnie rozwijające się środowisko AI, które z każdym rokiem zyskuje na znaczeniu na arenie międzynarodowej. Jestem przekonany, że jeszcze wiele usłyszymy o polskim wkładzie w tę fascynującą dziedzinę.

Przeczytaj również: Moja Biedronka: Sprawdź dostępność produktów i uniknij pustych półek!

Kolejny przełom czy kolejna zima? Najważniejsze wyzwania stojące przed AI

Patrząc w przyszłość, sztuczna inteligencja stoi przed szeregiem ekscytujących możliwości, ale także poważnych wyzwań. Czy czeka nas kolejny przełom, czy może kolejna "zima AI"? Wierzę, że jesteśmy na ścieżce ciągłego rozwoju, ale musimy być świadomi potencjalnych pułapek. Kluczowe wyzwania to przede wszystkim kwestie etyczne, takie jak bezstronność algorytmów, prywatność danych i odpowiedzialność za decyzje podejmowane przez AI. Niezwykle ważne jest również bezpieczeństwo systemów AI, aby zapobiec ich złośliwemu wykorzystaniu. Potrzebujemy także odpowiednich regulacji, które będą wspierać innowacje, jednocześnie chroniąc społeczeństwo. Z technicznego punktu widzenia, nadal dążymy do stworzenia prawdziwie ogólnej sztucznej inteligencji (AGI), która potrafi uczyć się i adaptować w wielu dziedzinach, a nie tylko w wąskich specjalizacjach. To ambitny cel, ale wierzę, że dzięki wspólnym wysiłkom badaczy i decydentów, AI będzie nadal służyć ludzkości, przynosząc korzyści, o których marzyliśmy od wieków.